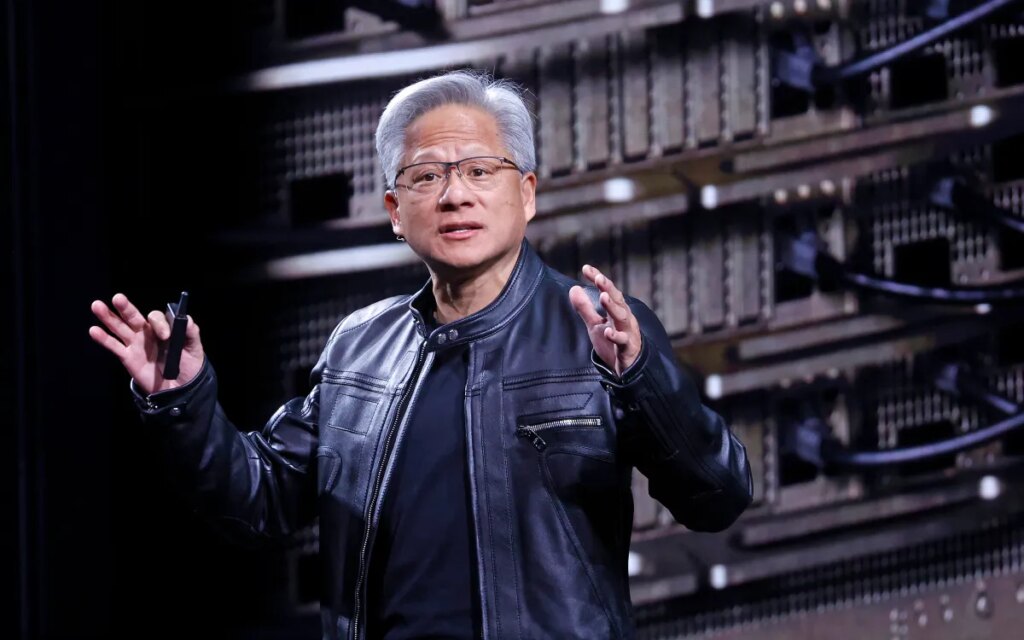

Hoy, en el Consumer Electronics Show, el director ejecutivo de Nvidia, Jensen Huang, presentó oficialmente la nueva arquitectura informática Ruby de la compañía, que describió como lo último en hardware de IA. La nueva arquitectura está actualmente en producción y se ampliará aún más en la segunda mitad del año.

“Vera Rubin fue diseñada para abordar este desafío fundamental que enfrentamos: la cantidad de computación requerida para la IA está aumentando rápidamente”. Huang le dijo a la audiencia. “Hoy les puedo decir que Vera Rubin está en plena producción”.

Anunciada por primera vez en 2024, la arquitectura Ruby es el último resultado del incansable ciclo de desarrollo de hardware de Nvidia que ha convertido a Nvidia en la empresa más valiosa del mundo. La arquitectura Rubin reemplazará a la arquitectura Blackwell, que a su vez reemplazó a las arquitecturas Hopper y Lovelace.

Los chips Ruby ya están programados para ser utilizados por casi todos los principales proveedores de nube, incluidas las asociaciones de alto perfil de Nvidia con Anthropic, OpenAI y Amazon Web Services. Los sistemas Rubin también se utilizan en la supercomputadora Blue Lion de HPE y en la próxima supercomputadora Doudna en el Laboratorio Nacional Lawrence Berkeley.

La arquitectura Rubin, que lleva el nombre de la astrónoma Vera Florence Cooper Rubin, consta de seis chips separados diseñados para usarse juntos. La atención se centra en la GPU Ruby, pero la arquitectura también aborda los crecientes cuellos de botella de memoria y conectividad con nuevas mejoras en los sistemas Bluefield y NVLink, respectivamente. La arquitectura también incluye una nueva CPU Vera diseñada para razonamiento agente.

Dion Harris, director senior de soluciones de infraestructura de IA en Nvidia, explicó los beneficios de la nueva memoria y señaló las crecientes necesidades de almacenamiento relacionadas con la caché de los sistemas de IA modernos.

“A medida que se empiezan a habilitar nuevos tipos de flujos de trabajo, como la IA de agentes o tareas de larga duración, eso genera mucha tensión y exigencias en su caché KV”, dijo Harris a los periodistas en una llamada telefónica, refiriéndose a un sistema de almacenamiento utilizado por los modelos de IA para comprimir las entradas. “Es por eso que introdujimos un nuevo nivel de almacenamiento que se conecta externamente al dispositivo informático, lo que le permite escalar su grupo de almacenamiento de manera mucho más eficiente”.

Evento tecnológico

san francisco

|

13 al 15 de octubre de 2026

Como era de esperar, la nueva arquitectura también representa un avance significativo en velocidad y eficiencia energética. Según las pruebas de Nvidia, la arquitectura Rubin funcionará tres veces y media más rápido en tareas de entrenamiento de modelos y cinco veces más rápido en tareas de inferencia que la arquitectura Blackwell anterior, alcanzando hasta 50 petaflops. La nueva plataforma también admitirá ocho veces más potencia de cálculo de inferencia por vatio.

Las nuevas capacidades de Rubin llegan en medio de una intensa competencia para construir infraestructura de IA, con laboratorios de IA y proveedores de nube compitiendo por los chips Nvidia y las instalaciones necesarias para ejecutarlos. En una convocatoria de resultados de octubre de 2025, Huang estimó que se gastarán entre 3 y 4 billones de dólares en infraestructura de inteligencia artificial durante los próximos cinco años.