Anthropic es la última empresa de inteligencia artificial (IA) en anunciar un nuevo conjunto de funciones que permitirán a los usuarios de su plataforma Claude comprender mejor su información de salud.

Como parte de una iniciativa llamada claudio por la saludLa compañía dijo que los suscriptores estadounidenses de los planes Claude Pro y Max pueden optar por brindarle a Claude acceso seguro a sus resultados de laboratorio y registros médicos conectándose a HealthEx y Function. Las integraciones de Apple Health y Android Health Connect se implementarán a finales de esta semana en las aplicaciones de iOS y Android.

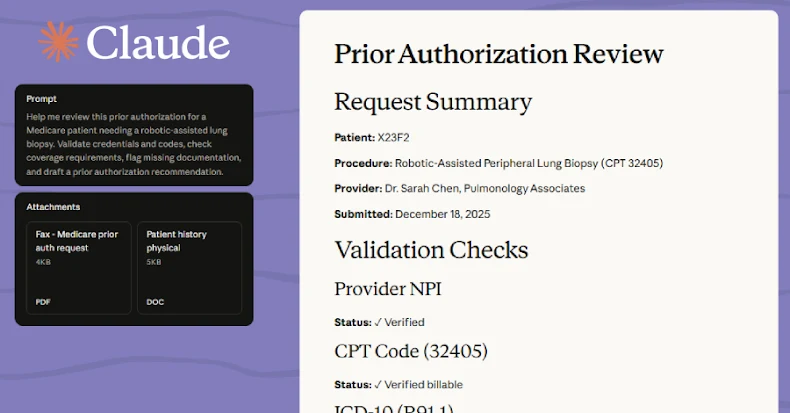

“Cuando está conectado, Claude puede resumir el historial médico de los usuarios, explicar los resultados de las pruebas en un lenguaje sencillo, identificar patrones en las métricas de salud y estado físico y preparar preguntas para las citas”, dijo Anthropic. “El objetivo es hacer que las conversaciones entre pacientes y médicos sean más productivas y ayudar a los usuarios a mantenerse bien informados sobre su salud”.

El desarrollo se produce pocos días después de que OpenAI presentara ChatGPT Health como una experiencia dedicada para que los usuarios conecten de forma segura registros médicos y aplicaciones de bienestar y reciban respuestas personalizadas, información de laboratorio, consejos nutricionales e ideas de comidas.

La compañía también señaló que las integraciones son de naturaleza privada y los usuarios pueden elegir explícitamente qué tipo de información quieren compartir con Claude y pueden deshabilitar o editar los permisos de Claude en cualquier momento. Al igual que OpenAI, los datos de salud no se utilizan para entrenar sus modelos.

La expansión se produce en medio de una creciente consideración sobre si los sistemas de inteligencia artificial pueden evitar ofrecer instrucciones dañinas o peligrosas. Recientemente, Google eliminó algunos de sus resúmenes de IA después de descubrir que contenían información de salud inexacta. Tanto OpenAI como Anthropic han enfatizado que sus ofertas de IA pueden cometer errores y no reemplazan el asesoramiento profesional de atención médica.

En la Política de uso aceptable, Anthropic establece que un profesional calificado en el campo debe revisar los resultados generados “antes de su distribución o finalización” en casos de uso de alto riesgo relacionados con decisiones de atención médica, diagnóstico médico, atención al paciente, terapia, salud mental u otra orientación médica.

“Claude está diseñado para incluir descargos de responsabilidad contextuales, reconocer su incertidumbre y dirigir a los usuarios a profesionales de la salud para obtener asesoramiento personalizado”, dijo Anthropic.